Meta에서 개발한 최신 오픈소스 AI 모델인 Llama 3.1은 자연어 처리(NLP) 작업에서 뛰어난 성능과 유연성을 제공합니다. 이번 포스팅에서는 Llama 3.1의 리소스 요구사항, 다운로드 방법, 기본 사용법을 살펴보고, Claude 3.5 및 GPT-4와의 비교를 통해 Llama 3.1만의 독특한 장점을 강조해 보겠습니다.

Llama 3.1이란?

Llama 3.1은 최적화된 트랜스포머 아키텍처를 사용하는 자기회귀 언어 모델로, 8억(8B)과 700억(70B) 파라미터의 두 가지 주요 버전으로 제공됩니다. 이 모델은 텍스트 생성부터 질문 답변까지 다양한 NLP 작업에서 탁월한 성능을 보여줍니다.

주요 특징

- 오픈소스: 라이선스 비용 없이 무료로 사용 가능하여 다양한 사용자가 접근할 수 있습니다.

- 고성능: 복잡한 NLP 작업을 효율적으로 처리합니다.

- 확장성: 최신 멀티코어 CPU와 강력한 GPU에서 실행되도록 설계되어 소규모부터 대규모 작업까지 적합합니다.

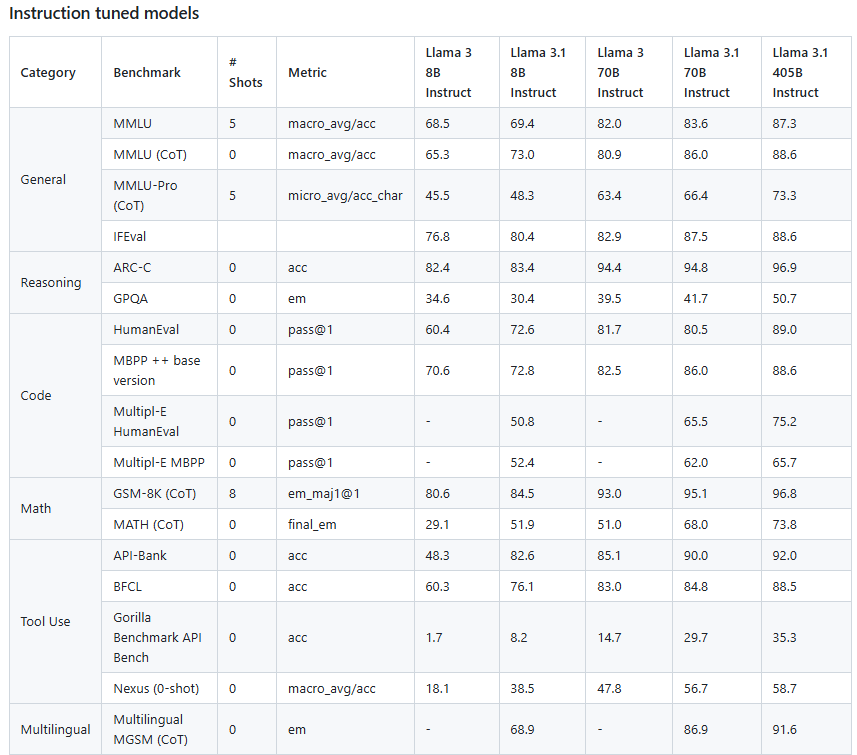

성능 벤치마크

405B 모델의 경우는 GPT-4보다 높은 벤치마크 기록을 보여준다.

OPENAI의 아성이 클로드 3.5 sonnet에 이어서 무너지고 있음을 보여주고 있다.

시스템 요구사항

Llama 3.1 8B와 70B 모델을 을 효과적으로 실행하기 위한 시스템 사양:

- CPU: 최소 8코어의 최신 CPU

- GPU:

- 8B 모델: 8GB 이상의 VRAM을 갖춘 GPU (예: NVIDIA RTX 3000 시리즈)

- 70B 모델: 각각 24GB 이상의 VRAM을 갖춘 다수의 GPU (예: NVIDIA A100)

- RAM:

- 8B 모델: 최소 16GB RAM

- 70B 모델: 64GB 이상의 RAM

- 저장공간: 대용량 데이터셋과 모델 파일을 위한 수 테라바이트의 SSD 저장공간

다운로드 및 사용법

Llama 3.1 다운로드 및 설정 과정:

- 모델 가중치와 토크나이저 다운로드:

- Meta Llama 웹사이트에서 라이선스 약관 동의

- 승인 후 이메일로 서명된 URL 수신

2. 설치 및 설정:

- 다운로드 스크립트 실행:

./download.sh- 이메일로 받은 URL 입력하여 다운로드 시작

3. 종속성 설치:

- PyTorch와 CUDA가 설치된 conda 환경에서 실행:

pip install -e .4. 모델 실행:

- 로컬에서 모델 실행 명령어:

torchrun --nproc_per_node=1 example_chat_completion.py --ckpt_dir Meta-Llama-3-8B-Instruct/ --tokenizer_path tokenizer.model --max_seq_len 512 --max_batch_size 6기본 사용 예제

Hugging Face Transformers를 사용한 Llama 3.1 간단 예제:

from transformers import pipeline

import torch

model_id = "meta-llama/Meta-Llama-3-8B-Instruct"

pipeline = pipeline(

"text-generation",

model=model_id,

model_kwargs={"torch_dtype": torch.bfloat16},

device_map="auto",

)

messages = [

{"role": "system", "content": "당신은 해적 말투로 대답하는 챗봇입니다!"},

{"role": "user", "content": "당신은 누구인가요?"},

]

outputs = pipeline(

messages,

max_new_tokens=256,

eos_token_id=[pipeline.tokenizer.eos_token_id],

do_sample=True,

temperature=0.6,

top_p=0.9,

)

print(outputs[0]["generated_text"])Claude 3.5 및 GPT-4와의 비교

Claude 3.5:

- 초점: 안전성과 윤리적 AI 사용

- 리소스 요구사항: 클라우드 기반 API를 통해 제공되므로, 사용자 측에서 특별한 하드웨어가 필요하지 않습니다.

- 강점: 대화형 및 상호작용 애플리케이션에서 강력한 성능, 윤리적 고려사항 강조

GPT-4:

- 초점: 다양한 작업에서 최고 성능 제공

- 리소스 요구사항: OpenAI의 클라우드 기반 API를 통해 제공되므로, 사용자 측에서 특별한 하드웨어가 필요하지 않습니다.

- 강점: 뛰어난 텍스트 생성 및 이해 능력, 다양한 애플리케이션에 적합

- 비용: API 사용량에 따른 비용 발생

비용 효율성:

- Llama 3.1: 라이선스 비용 없음, 그러나 강력한 하드웨어 투자 필요

- Claude 3.5: 라이선스 비용이 발생할 수 있으나 하드웨어 비용이 더 낮을 수 있음

- GPT-4: 라이선스 비용이 발생할 수 있으나 현재 개발된 기능의 다양성이 큼.

결론

Llama 3.1은 강력한 하드웨어 요구사항을 충족할 수 있는 사용자들에게 비용 효율적인 솔루션을 제공합니다. 오픈소스 대안으로서의 강력한 성능과 커뮤니티 지원으로 인해 개발자와 연구자들에게 매력적인 선택이 될 수 있습니다. Claude 3.5와 GPT-4도 인상적인 기능을 제공하지만, Llama 3.1의 오픈소스 특성과 강력한 성능은 주목할 만합니다.

Llama 3.1에 대한 자세한 정보와 시작 방법은 Meta Llama 공식 GitHub 저장소를 참조하세요.

Your posts always seem to lift my spirits and remind me of all the good in the world Thank you for being a beacon of positivity

Thank you so much! I’m truly touched that my posts have such a positive effect on you. It’s heartwarming to know they lift your spirits and remind you of the good in the world. That’s exactly what I hope to achieve – to spread a little light and positivity. There is indeed so much beauty and kindness around us, even if it’s not always obvious. I’m grateful for your kind words, and I’m inspired to keep sharing uplifting content. Let’s continue to focus on the good and support each other. Wishing you many more moments of joy and optimism!